I kapplöpningen om att bygga världens mest kraftfulla infrastruktur för artificiell intelligens har Cisco just lagt i en ny växel. Med lanseringen av Silicon One G300 introducerar nätverksjätten ett chip som inte bara lovar högre hastigheter, utan också en arkitektur skräddarsydd för att hantera de enorma datamängder som krävs för modern AI-träning.

Det är ingen hemlighet att AI-modeller växer i en takt som hårdvaran kämpar för att matcha. Flaskhalsen är ofta inte själva beräkningskraften, utan förmågan att flytta data snabbt nog mellan tusentals processorer. Det är här Ciscos nya flaggskepp, Silicon One G300, kliver in på scenen som en potentiell “game changer” för storskaliga kluster.

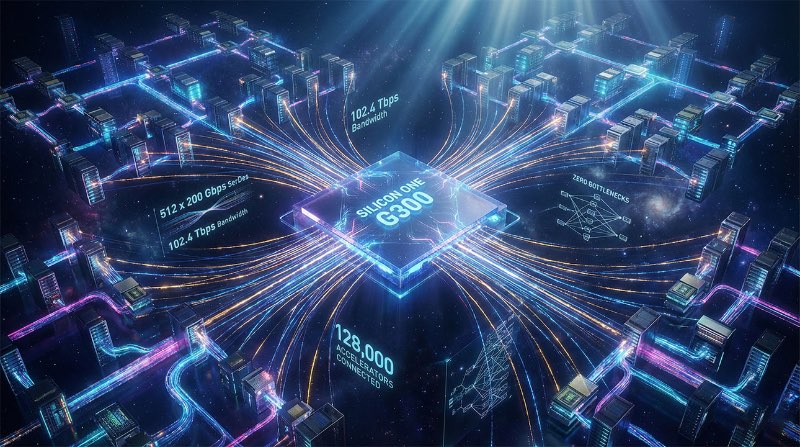

En motorväg för data på 102.4 Tbps

Hjärtat i G300 är dess enorma bandbredd. Chippet är en 102.4 Tbps-switch designad specifikt för AI-träning och inferens. För att sätta detta i perspektiv har Cisco utrustat hårdvaran med 512 så kallade serializers/deserializers (SerDes) som opererar vid 200 Gbps.

Denna tekniska konfiguration möjliggör port-hastigheter på upp till 1.6 Tbps. Det handlar inte bara om råstyrka; det handlar om skalbarhet. Enligt de tekniska specifikationerna tillåter G300:s “radix” (antalet anslutningar chippet kan hantera) att man bygger nätverk som kopplar samman hela 128 000 GPU:er med hjälp av endast 750 switchar. Det är en arkitektur byggd för de allra största superdatorerna.

Arkitektur som eliminerar köbildning

Men hastighet är ingenting utan kontroll. I traditionella nätverk kan “traffic congestion” – digitala bilköer – snabbt sänka prestandan i ett AI-kluster. Cisco har därför implementerat flera nyckelkomponenter för att lösa detta.

G300 använder en “collective networking engine” parad med en helt delad paketbuffert (fully shared packet buffer). Tillsammans med en vägbaserad lastbalanserare (path-based load balancer) är systemet designat för att aktivt motverka trängsel i nätverket. Istället för att data fastnar på en överbelastad lina, ser chippet till att informationen flyter den mest effektiva vägen.

Resultatet av denna ingenjörskonst är påtagligt. Cisco hävdar att deras implementation uppnår 33 procent bättre länkutnyttjande jämfört med standardlösningar.

Snabbare träning, hårdare konkurrens

Vad betyder då alla dessa siffror i praktiken för de företag som utvecklar nästa generations AI? Tid är pengar, och enligt Cisco kan G300 reducera tiden det tar att träna en AI-modell med upp till 28 procent. I en bransch där träningsrundor kan ta veckor eller månader, är en sådan tidsbesparing enormt värdefull.

Lanseringen innebär också att konkurrensen hårdnar betydligt i toppen av näringskedjan för nätverkshårdvara. Med Silicon One G300 ställer sig Cisco i direkt konfrontation med andra tungviktare på marknaden. Produkten konkurrerar nu öga mot öga med Broadcoms Tomahawk 6 och Nvidias Spectrum-X Ethernet Photonics.

Det står klart att striden om vem som ska bygga ryggraden i framtidens AI-fabriker bara har börjat, och Cisco har just placerat en mycket tung pjäs på spelbrädet.